Чи виникало у вас бажання фізично зобразити картину, яка виникла у вашій уяві? Щоб мати можливість представити її іншим людям не через опис, сподіваючись, що вони правильно зрозуміють, що ви маєте на увазі, і відтворять її у себе в голові, а безпосередньо – ніби витягнувши її зі своєї уяви і представивши на загальний огляд? А може, щоб просто чіткіше побачити картину, яка виникла у вашій уяві, побачити її реальним зором, а не лише образно, за допомогою уяви?

Хоча технологію, що читає думки, ще не вигадали, тим часом у нас є цікава альтернатива. Зараз ми живемо в епоху моделей штучного інтелекту, здатних генерувати високоякісні зображення на основі виключно текстового опису. До того ж, ця технологія безкоштовна, з відкритим кодом і доступна кожному.

Як же ми цього досягли? У цій статті представлено коротку історію синтезу зображень, що дає змогу поглянути з висоти пташиного польоту на ключові події, які дозволили досягти поточного результату.

Генеративно-змагальні мережі

Хоча перші спроби створення зображень за допомогою штучного інтелекту датуються 1970-ми роками, протягом десятиліть прогрес у цій галузі був незначним. Доступні обчислювальні потужності та обсяги даних були обмежені, а алгоритми – занадто примітивними і негнучкими, що не давало змоги обробляти більш складні та реалістичні зображення. Однак ситуація почала змінюватися з розвитком глибокого навчання та конволюційних нейронних мереж, які, у свою чергу, стали основою для генеративно-змагальних мереж (Generative Adversarial Networks, GAN).

GAN стали значним проривом у галузі зображень, створених за допомогою штучного інтелекту. Цю архітектуру нейронної мережі розробив у 2014 році Ян Гудфеллоу спільно зі своїми колегами з Монреальського університету. Вона складається з двох нейронних мереж: генератора і дискримінатора, які навчаються по черзі. Мережа-генератор вчиться генерувати синтетичні дані, які імітують розподіл реальних даних, тоді як мережа-дискримінатор вчиться відрізняти синтетичні дані, згенеровані генератором, від реальних даних.

Процес навчання є ітеративним: генератор намагається створити синтетичні дані, які можуть обдурити дискримінатор, а дискримінатор вдосконалює свою здатність розрізняти справжні та фальшиві дані.

Кінцевим результатом є генератор, здатний створювати синтетичні дані, які візуально або на слух не відрізняються від реальних. Цей загальний підхід можна використовувати не лише для синтезу зображень, але й для виконання інших завдань, таких як передача стилю або доповнення даних, а також застосовувати поза візуальною сферою, наприклад, для генерації звуку і синтезу музики.

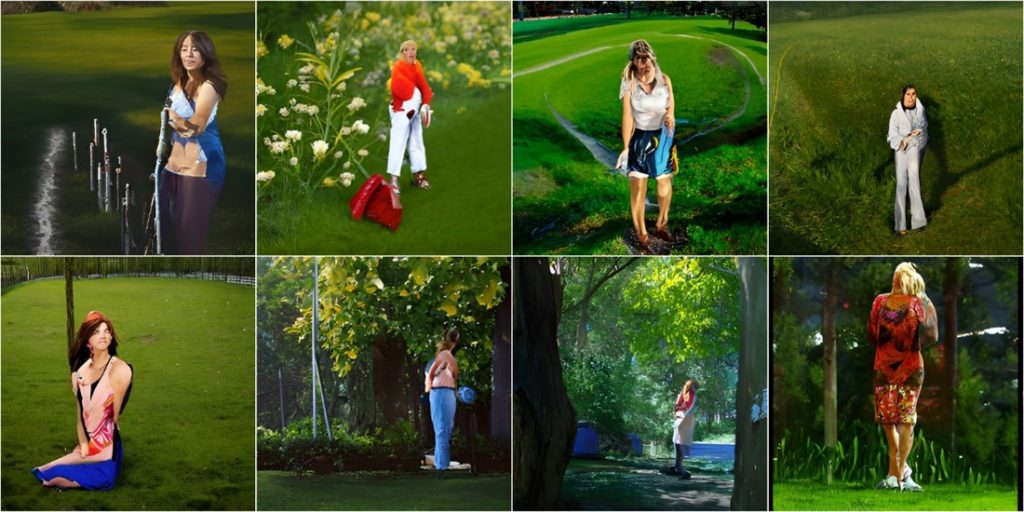

Цей підхід виявився успішним в рамках створення високоякісних зображень, і вони були використані в різних додатках, таких як генерація зображень облич, пейзажів і об’єктів. Крім того, GAN були адаптовані для виконання й інших завдань, включаючи створення детальних зображень з приблизних ескізів, перенесення стилю одного зображення на інше або заміну фрагментів зображення на потрібний об’єкт.

Обмеження технології GAN

Однак, хоча GAN продемонстрували вражаючі результати у створенні реалістичних зображень, цій технології властива і низка обмежень. Одним з таких обмежень є нестабільний характер процесу навчання. Змагальна структура мережі може призвести до колапсу режиму, коли мережа-генератор виробляє лише обмежений набір зображень, які не охоплюють увесь діапазон можливих результатів, що призводить до недостатньої різноманітності вихідних зображень.

Ще однією проблемою, до якої можуть бути особливо чутливі GAN, є перенавчання, коли мережа-генератор запам’ятовує навчальний набір даних замість того, щоб узагальнювати його з метою створення нових зображень. Крім того, GAN можуть мати труднощі зі створенням зображень високої роздільної здатності через складність обчислень, що часто вимагає значного часу і обчислювальних потужностей для навчання.

Крім того, хоча існують приклади версій GAN, які перетворюють текст на зображення, або моделі, які перетворюють зображення на текст, більшість реалізацій надають обмежений контроль над згенерованим результатом, що ускладнює створення певних об’єктів або зміну стилю згенерованих зображень без значного додаткового навчання або маніпуляцій.

DALL-E

Щоб подолати ці обмеження, дослідники продовжують вивчати нові методи та архітектури для генерації зображень. Одним з таких прикладів є DALL-E, розроблений OpenAI і випущений 5 січня 2021 року. У моделі використовується генеративний попередньо навчений трансформатор, який, у свою чергу, базується на більш ранній моделі трансформатора. Обидві моделі спочатку були розроблені для використання в обробці природної мови.

Модель Transformer – це нейромережева архітектура, в основі якої лежить механізм самонавчання. У традиційних нейронних мережах кожен вхідний елемент обробляється окремо, що може призвести до труднощів з моделюванням довготривалих залежностей. Механізм уваги дозволяє моделі вибірково зосереджуватися на різних частинах вхідної послідовності, що дає їй змогу вловлювати складні зв’язки між словами.

Модель Transformer складається з кодера та декодера, обидва з яких складаються з декількох шарів нейронних мереж із самонавчанням та прямим зв’язком. Вона добре розпаралелюється і досягла найкращих результатів у багатьох задачах обробки природної мови.

На основі цієї архітектури у 2018 році компанія OpenAI розробила Генеративні попередньо навчені трансформатори (Generative Pre-trained Transformers). GPT працює шляхом навчання великої нейронної мережі на великих обсягах текстових даних, таких як книги, статті та веб-сайти. У моделі використовується процес, який називається неконтрольованим навчанням, для виявлення закономірностей і взаємозв’язків у даних, не отримуючи чітких вказівок стосовно того, що це за закономірності.

Після того, як модель буде навчена, її можна буде використовувати для створення нового тексту, передбачаючи наступне слово або послідовність слів на основі контексту попередніх слів у реченні. Це робиться за допомогою процесу, який називається авторегресією, коли модель генерує по одному слову за раз на основі розподілу ймовірності наступного слова з урахуванням попередніх слів.

Початкова версія GPT була масштабована у 2019 році, а потім ще раз у 2020 році, в результаті чого з’явився GPT-3, що використовує 175 мільярдів параметрів. Ця модель лягла в основу для DALL-E, яка використовує її мультимодальну реалізацію із застосуванням 12 мільярдів параметрів, яка замінює текст на пікселі, що виливаються на пари текст-зображення з Інтернету.

Модель DALL-E продемонструвала видатні результати в численних завданнях генерації зображень на основі текстових вхідних даних. Окрім простого генерування зразків зображень різних об’єктів, які вона бачила під час навчання, модель вміє інтегрувати різні ідеї та переконливо поєднувати не пов’язані між собою поняття і навіть генерувати об’єкти, існування яких у фізичному світі є малоймовірним.

CLIP

Ще одним важливим кроком у синтезі зображень зі штучним інтелектом, представленим разом з DALL-E, стала методика під назвою Контрастне попереднє навчання мови і зображень (Contrastive Language-Image Pre-training). CLIP – це модель, навчена на 400 мільйонах пар текстових підписів і зображень, причому підписи були взяті з Інтернету. Вона передбачає навчання нейромережевої моделі як на текстових даних, так і на зображеннях, щоб навчити модель розуміти взаємозв’язок між двома модальностями – яким чином текстові описи співвідносяться з візуальним змістом зображень.

Під час навчання модель вчиться кодувати вхідні зображення і текст у спільний векторний простір, де схожість між зображенням і відповідним текстовим описом є максимальною, тоді як схожість між зображеннями та іншими нерелевантними текстами є мінімальною. Це досягається за допомогою функції контрастивних втрат, яка спонукає модель зближувати вектори зображення і тексту, що належать до однієї пари «зображення-підпис», і відштовхувати вектори зображення і тексту, що не належать до однієї пари.

У DALL-E модель CLIP використовувалася для ранжування згенерованих зображень за точністю підписів, щоб відфільтрувати початковий набір зображень і вибрати найбільш підходящі результати. Відтоді модель CLIP стала популярним елементом, яка використовується в різних рішеннях для синтезу зображень, виконуючи роль фільтра і керівництва в процесі генерації зображень моделей.

Першим рішенням з відкритим вихідним кодом, в якому було використано цю технологію, було DeepDaze, розроблене у січні 2021 року Філом Вангом. Він поєднав CLIP з неявною нейронною мережею представлення під назвою Siren. Рішення DeepDaze здобуло популярність завдяки своїй здатності створювати візуально приголомшливі та сюрреалістичні зображення, які часто нагадують казкові пейзажі або абстрактне мистецтво.

BigSleep

Кількома днями пізніше той самий розробник за допомогою моделей, опублікованих дослідником Райаном Мердоком, розробив ще одну генеративну модель глибокого навчання під назвою BigSleep. Модель працює, поєднуючи CLIP з BigGAN – системою, розробленою дослідниками з Google, яка використовує варіант архітектури GAN для генерації зображень високої роздільної здатності з випадкових векторів шуму. BigSleep використовує результати BigGAN для пошуку зображень, які мають високий рейтинг у CLIP. Потім модель поступово регулює вхідний шум у генераторі BigGAN, доки створені зображення не будуть відповідати заданому запиту.

За словами Райана Мердока, BigSleep стала першою моделлю, яка змогла згенерувати різноманітні концепції та об’єкти з високою якістю при роздільній здатності 512 x 512 пікселів. У той час як попередні роботи, хоч і давали вражаючі результати, часто обмежувалися зображеннями з нижчою роздільною здатністю і більш поширеними об’єктами.

The VQGAN-CLIP

Модель BigSleep надихнула на створення ще однієї комбінації CLIP-GAN. Лише через три місяці, у квітні 2021 року, дослідниця Кетрін Кроусон розробила модель VQGAN-CLIP. Векторна квантована генеративно-змагальна мережа (Vector Quantized Generative Adversarial Network, VQGAN) є варіантом архітектури генеративно-змагальної мережі. Вона здатна генерувати високоякісні зображення шляхом кодування зображень у вигляді дискретних записів кодової книги, що дозволяє більш ефективно навчати і покращувати якість зображень порівняно з традиційними моделями GAN.

У моделі VQGAN-CLIP використовується мультимодальний кодер CLIP для оцінки схожості пари (текст-зображення) і її повернення через мережу в латентний простір (тобто простір абстрактних зображень) генератора зображень VQGAN. Шляхом ітеративного повторення цього процесу згенерований кандидат на зображення коригується до тих пір, поки він не стане більш схожим на цільовий текст.

Модель дозволяла не лише генерувати зображення, але й надавала можливість виконувати маніпуляції з уже існуючими зображеннями, надаючи текстовий опис змін, які необхідно запровадити. Ця архітектура стала важливим кроком у розвитку моделей перетворення тексту на зображення, забезпечуючи високоякісну генерацію зображень і маніпуляції з ними, семантичну точність між текстом і зображенням, а також ефективність навіть під час створення малоймовірного контенту. Відкритий підхід до розробки та досліджень цієї моделі сприяв її швидкому успіху в реальному світі, а особі, які не були її авторами, стрімко поширили її на інші модальності та комерційні сфери застосування.

Дифузійні моделі

Напрям досліджень, заснованих на поєднанні CLIP з іншими архітектурами, продовжився. У червні 2021 року автор VQGAN-CLIP випустив ще одну роботу, об’єднавши модель контрастного попереднього навчання мови-зображення з алгоритмом дифузії для створення CLIP Guided Diffusion.

Алгоритми дифузії – це сімейство імовірнісних методів генерації зображень, заснованих на моделюванні поведінки частинок, що дифундують через середовище. Дані зображення можна перетворювати на рівномірний розподіл шляхом додавання випадкового шуму. Алгоритм дифузії повільно погіршує структуру зображення, додаючи шум, поки не залишиться нічого, крім випадкового шуму.

У машинному навчанні метою є вивчення процесу зворотної дифузії – віднайдення параметрів процесу, який ітеративно перетворює випадковий шум назад на когерентну картину. Цей процес реконструкції зумовлений певним сигналом наведення.

Як працює алгоритм?

Загалом алгоритм працює наступним чином:

- Алгоритм ініціалізує дані випадково згенерованим шумовим сигналом – як правило, гаусівським розподілом з нульовим середнім значенням та одиничною дисперсією.

- Шумовий сигнал використовується як початковий стан процесу дифузії, і з цього початкового розподілу відбираються частинки, що представляють положення пікселів зображення.

- Імітується дифузія частинок, котра моделюється як послідовність часових кроків, під час кожного з яких позиції частинок оновлюються на основі імовірнісного правила, що моделює дифузію.

- Процес обумовлений сигналом підказки – зображенням або текстовою підказкою.

- Сигнал використовується для зміщення дифузії в бік формування зображення з потрібними характеристиками.

- Етапи дифузії та кондиціонування повторюються ітеративно протягом фіксованої кількості кроків.

- Під час процесу частинки стають більш сконцентрованими в областях, які відповідають сигналу наведення.

- Після завершення процесу дифузії остаточне положення частинок перетворюється на зображення за допомогою нейромережевого декодера.

- За бажанням, для покращення якості зображення виконуються додаткові кроки постобробки, такі як корекція кольору або знебарвлення.

У CLIP Guided Diffusion автор використовував керованої дифузії (Guided Diffusion) – реалізацію алгоритму дифузії дослідників з OpenAI, що керується сигналом, наданим CLIP. У цій архітектурі модель CLIP використовується для отримання набору зображень, які відповідають текстовій підказці, які слугують вказівками для моделі Guided Diffusion. Користувач також може вказати додаткові обмеження стосовно бажаного зображення, наприклад, роздільну здатність зображення або кольорову палітру.

Потім модель Guided Diffusion генерує послідовність векторів шуму, які поступово уточнюються, щоб створити зображення, яке відповідає вказівкам, наданим CLIP. Модель ітеративно оновлює вектори шуму, визначаючи їх на основі попереднього вектора шуму, сигналу наведення, наданого CLIP, і випадкового дифузійного шуму. Далі отримані вектори шуму перетворюються на зображення за допомогою нейромережевого декодера.

Переваги та недоліки моделі CLIP Guide Diffusion

Доведено, що CLIP Guided Diffusion створює високоякісні зображення з реалістичними текстурами та дрібними деталями, яких важко досягти за допомогою інших генеративних моделей. Однак, мабуть, ще важливішою є та обставина, що ця модель чутливо реагує на управління, що дозволяє користувачам створювати зображення, які відповідають певним стилям або характеристикам, зазначеним у текстовій підказці. Модель можна використовувати для виконання широкого спектру завдань, пов’язаних із генерацією зображень, включно з редагуванням зображень, синтезом зображень і маніпуляціями з ними.

Цей винахід спричинив вибух інтересу до генерації зображень, поширивши знання про технологію серед широкої аудиторії. Невдовзі після моделі Кроусона з’явився Disco Diffusion – популярний блокнот Google Colab, у якому було використано CLIP Guided Diffusion, щоб отримати простий у використанні інтерфейс і велику кількість налаштувань. Цей інструмент стрімко набув популярності серед художників та любителів ШІ, які отримали ще простіший і зручніший доступ до технології, котра раніше була доступна лише дослідникам у великих технологічних компаніях.

Одним з недоліків дифузійних моделей є те, що вони вимагають багато обчислень для навчання та запуску, але подальший їх розвиток мав би змінити цю ситуацію.

Розвиток технологій

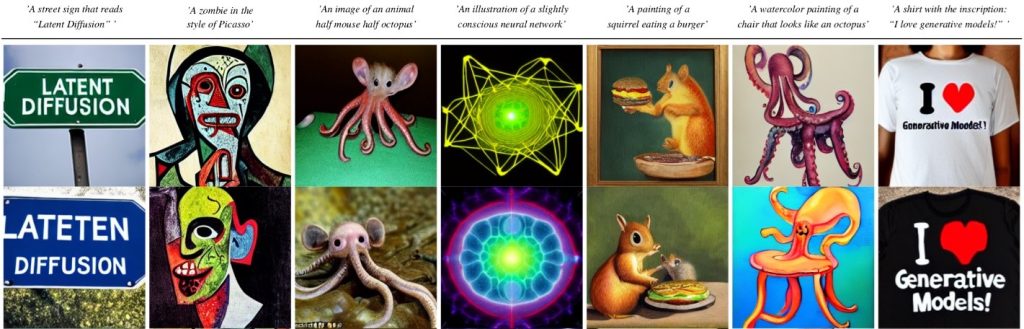

У грудні 2021 року група вчених з команди CompVis Мюнхенського університету LMU представила свій погляд на популярну техніку – латентну дифузію (Latent Diffusion). Цей алгоритм запропонував більш ефективну альтернативу класичним моделям дифузії.

Замість того, щоб працювати з оригінальним зображенням, він запустив процес дифузії в стислому представленні зображення, відомому як латентний простір. Працюючи в цьому просторі, алгоритм міг реконструювати зображення, мінімізуючи при цьому обчислювальне навантаження. Крім того, алгоритм був універсальним з точки зору вхідних даних, і мав здатність працювати з різними типами, включаючи зображення і текст.

Спершу початкове зображення кодується в латентний простір, звідки витягується найбільш релевантна інформація, яка потім представляється в меншому підпросторі. Цей процес є аналогом зменшення вибірки, в рамках якого розмір даних зменшується зі збереженням важливих ознак. Потім той самий процес застосовується до будь-яких вхідних даних, які визначають умови, таких як текст або додаткові зображення, котрі об’єднуються з поточним представленням зображення за допомогою механізму уваги.

Цей механізм навчається оптимально комбінувати загальні вхідні дані і вхідні дані, які визначають умови, у латентному просторі. Далі об’єднані вхідні дані використовуються як початковий шум для процесу дифузії, який відбувається в латентному підпросторі. Нарешті, зображення реконструюється за допомогою декодера, котрий можна розглядати як процес, обернений до кроку кодування.

Латентна дифузія виявилася здатною генерувати високоякісні, різноманітні та реалістичні зображення. Вона дозволяє створювати різні зразки – від простих і гладких до складних і деталізованих. Це була гнучка і масштабована архітектура моделі, яку можна було навчати на великих наборах даних, щоб підвищити її точність і здатність до узагальнення. Вона стала важливим кроком у розвитку моделей перетворення тексту на зображення.

Лихоманка генерації зображень на базі штучного інтелекту

Моделі штучного інтелекту, що перетворюють текст на зображення, пройшли довгий шлях всього за кілька років, але до 2022 року залишалися досить обмеженими. Багато ранніх моделей вимагали великих обчислювальних потужностей для запуску, особливо на етапі навчання. Відповідно, вони часто навчалися на невеликих наборах даних, залишаючись, таким чином, цікавими переважно для дослідників. Деякі цікаві технології були доступні через блокноти Google Colab, що дозволяли легко виконувати код на обладнанні, доступному через хмарний сервіс. Однак цей метод все ще вимагав певної технічної компетентності, що обмежувало популярність технології, яка лежала в його основі.

Ситуація почала змінюватися у 2022 році, відколи почали з’являтися нові додатки, які забезпечують зручні інтерфейси для моделей, заснованих здебільшого на певному форматі реалізації дифузійної моделі.

У березні 2022 року незалежна дослідницька лабораторія MidJourney запустила відкриту бета-версію свого додатку, що надає доступ до високоякісної генерації художньо стилізованих зображень за допомогою чат-бота, доступного через комунікаційний додаток Discord. Хоча сервіс вимагає оплати за постійне використання, він дозволяє новим користувачам створити обмежену кількість зображень безкоштовно.

Незабаром після цього, у квітні, відбувся запуск ще одного масштабного веб-сервіс синтезу зображень. DALL-E 2 від OpenAI, який раніше був доступним лише обмеженій аудиторії, став відкритим для широкого загалу. Як і MidJourney, він вимагає купівлі кредитів для створення зображень, але щомісяця безкоштовно пропонує невелику кількість кредитів, що не накопичуються.

DALL-E 2 було створено шляхом навчання нейронної мережі на парах зображення і текстового опису. Вона може не лише розуміти об’єкти, поєднуючи текстові описи із зображеннями, але й розуміти зв’язки між об’єктами. Як і багато інших сучасних моделей, цей додаток використовує в процесі синтезу зображень алгоритм дифузії.

DALL-E 2 використовує CLIP для вивчення зв’язків між текстовою семантикою опису зображень та їх візуальним представленням, кодуючи зображення у простір представлення. Далі модифікована версія однієї з попередніх моделей OpenAI, GLIDE, використовується для інвертування процесу кодування зображення з метою стохастичного декодування вкладених зображень, створених CLIP. Це допомагає створювати варіанти вхідних даних, які, хоча і відрізняються від оригінального зображення або текстової підказки, все одно можуть дати результати, що відображають визначальні риси наданих вхідних даних.

Ця архітектура перевершує попередню версію за фотореалістичністю та відповідністю підписам. Окрім покращення продуктивності, вона також пропонує додаткові можливості, окрім простого синтезу тексту в зображення, такі як:

- inpainting (створення конкретних об’єктів і їх об’єднання у ширшу картину),

- outpainting (створення візуально узгоджених продовжень вхідного зображення),

- створення варіацій вхідних зображень.

Варто також згадати реалізацію DALL-E з відкритим вихідним кодом під назвою Craiyon (раніше DALL-E Mini, перейменовану через юридичну суперечку з OpenAI), яку виконав незалежний розробник та інженер з машинного навчання Борис Дайма. Вона не може зрівнятися за якістю з оригінальною архітектурою DALL-E, але здобула певну популярність за межами ШІ-спільноти через інтернет-меми завдяки своїм часто безглуздим результатам.

Окрім цих двох масштабних додатків, у першій половині 2022 року вийшло багато інших цікавих проєктів. У травні Google анонсував систему генерації зображень Imagen, яка може скласти конкуренцію DALL-E, а в червні оприлюднив Parti – ще одну модель перетворення тексту на зображення. Заслуговують на увагу і публікації компанії Microsoft про її підхід до генерації зображень – NUWA та NUWA Infinity. Кожна з цих архітектур привнесла цікаві результати та варіації на тему раніше розроблених методів. На жаль, жодна з них не є доступною для тестування широкому загалу, а їх детальний опис виходить за рамки цієї статті.

Становлення Stable Diffusion

У липні 2022 року відбувся реліз моделі, яка здобула, мабуть, найбільшу популярність – стабільна дифузія (Stable Diffusion). Модель була розроблена тими ж людьми, які раніше працювали над моделлю латентної дифузії. Завдяки більшому набору навчальних даних та покращенню структури моделі, вона перевершує свою попередницю як за якістю зображень, так і за діапазоном можливостей. Стабільна дифузія зумовлює синтез зображень за допомогою замороженого текстового кодера CLIP ViT-L/14, інтегрованого в архітектуру моделі та навченого на наборі даних LAION-2B, який містить 2,32 мільярда пар «зображення-текст» англійською мовою.

Попри свої розміри, цей метод є відносно легким після навчання: доступно 860 мільйонів параметрів для моделі UNet і 123 мільйони параметрів для текстового кодера (порівняно, наприклад, з 3,5 мільярдами параметрів для DALL-E 2). Спочатку її можна було запускати на графічному процесорі зі щонайменше 10 ГБ VRAM, тоді як останні оптимізації зменшили обсяг необхідної пам’яті до 6 ГБ, причому деякі користувачі повідомляють про її успішне виведення на картах Nvidia з усього 4 ГБ VRAM.

Якщо порівнювати Stable Diffusion безпосередньо з DALL-E 2 і MidJourney, то первинні результати іноді можуть здатися гіршими. Вільний доступ і відкритий характер Stable Diffusion означає, що за допомогою розумного інжинірингу найсучасніші синтетичні зображення легко доступні кожному.

Крім того, гнучкість і масштабованість архітектури дозволили модифікувати оригінальну модель, допрацьовуючи її на менших наборах зображень, створюючи спеціалізовані моделі для генерації зображень у певних стилях і з бажаними сценами, об’єктами і людьми. Нові технології, такі як Dreambooth і LoRA, спрощують цей процес, дозволяючи відносно швидко налаштовувати і додавати індивідуальні концепції до моделі, використовуючи невеликі набори даних, що складаються з кількох десятків зображень. Завдяки цьому інтерес до моделі Stable Diffusion з моменту її появи стрімко зріс.

На сьогоднішній день існує безліч способів запуску моделі, включаючи веб-додатки, чат-боти Discord і блокноти Google Colab, і це далеко на всі хмарні можливості. Крім того, існує безліч безкоштовних додатків з відкритим вихідним кодом, які надають інтерфейс користувача для моделі, що дозволяє будь-якому користувачеві легко використовувати її численні функції на власному обладнанні. Завдяки новим функціям і додатковим моделям, наданим як іншими дослідниками, так і спільнотою незалежних розробників, моделі Stable Diffusion зняла обмеження для творчості, розпочавши нову еру вільної і широкодоступної генерації зображень на основі ШІ.

Підсумок

Історія синтезу зображень на основі штучного інтелекту – це захоплива подорож, що охоплює десятиліття досліджень з усього світу. Це історія, сповнена ретельних наукових досліджень, співпраці та несподіваних винаходів. Від ранніх процедурних алгоритмів, генеративно-змагальних мереж, міждоменного синтезу обробки природної мови та генерації зображень у CLIP і GPT до проривів, забезпечених дифузійними моделями, – ця технологія є свідченням швидкості, з якою можна досягти прогресу.

Все, що потрібно – це щоб вчені та інженери вільно і відкрито використовували напрацювання один одного, постійно спираючись на попередні досягнення і далі розширюючи межі людської винахідливості.

Завдяки своєму величезному руйнівному потенціалу ця технологія вже здобула як відданих прихильників, так і запеклих ворогів. Багато графічних дизайнерів і художників обурені тим, що їхню роботу використовують для навчання моделей штучного інтелекту, які можуть поставити під загрозу існування їхньої професії, і тому вони вирішили протестувати або навіть судитися з компаніями, що стоять за цими рішеннями. Проте інші організації активно працюють над інтеграцією технології у свої процеси та створенням нових рішень на її основі.

Як саме розгортатимуться події далі поки що невідомо, але одне можна сказати напевно: синтез зображень за допомогою штучного інтелекту здатен здійснити революцію в мистецтві, промисловості… і, можливо, у всьому суспільстві!